AIOps在运维系统中的整合-troubleshooting

探索大模型在运维工作中的方向,此篇主要讲故障排查。是“Autogen 运维排错实践-复杂案例”的进一步整合,改进如下

- 通过跳板机,不需要在目标机器安装agent,零侵入

- 入口统一,集成在运维系统

- 模型自由切换,GPT-4/Claude/tongyi等等

效果

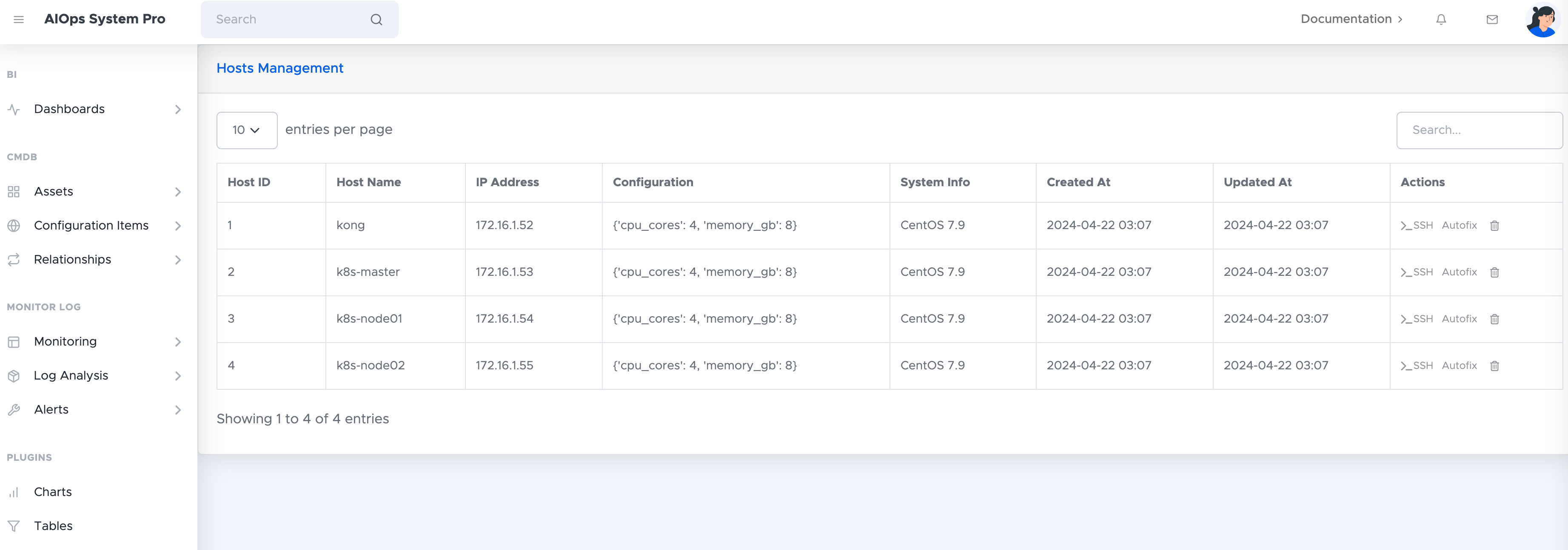

用户在资产中选择目标机器

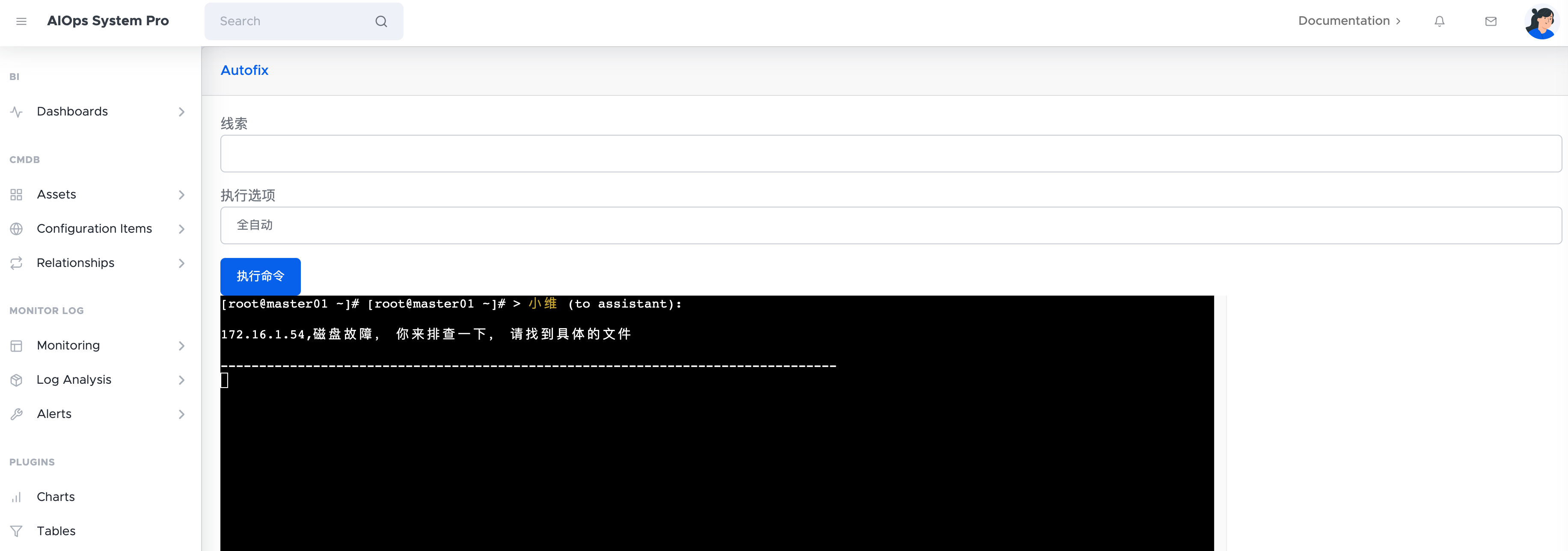

描述故障,选择策略(自动执行、逐步询问),点击执行

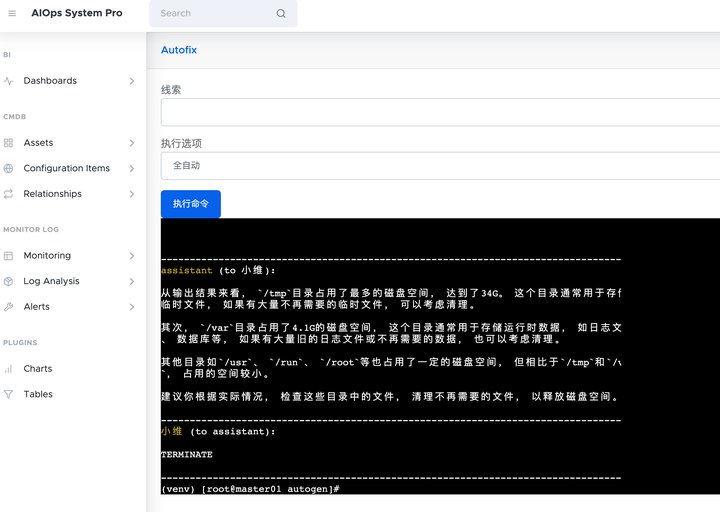

输出结果

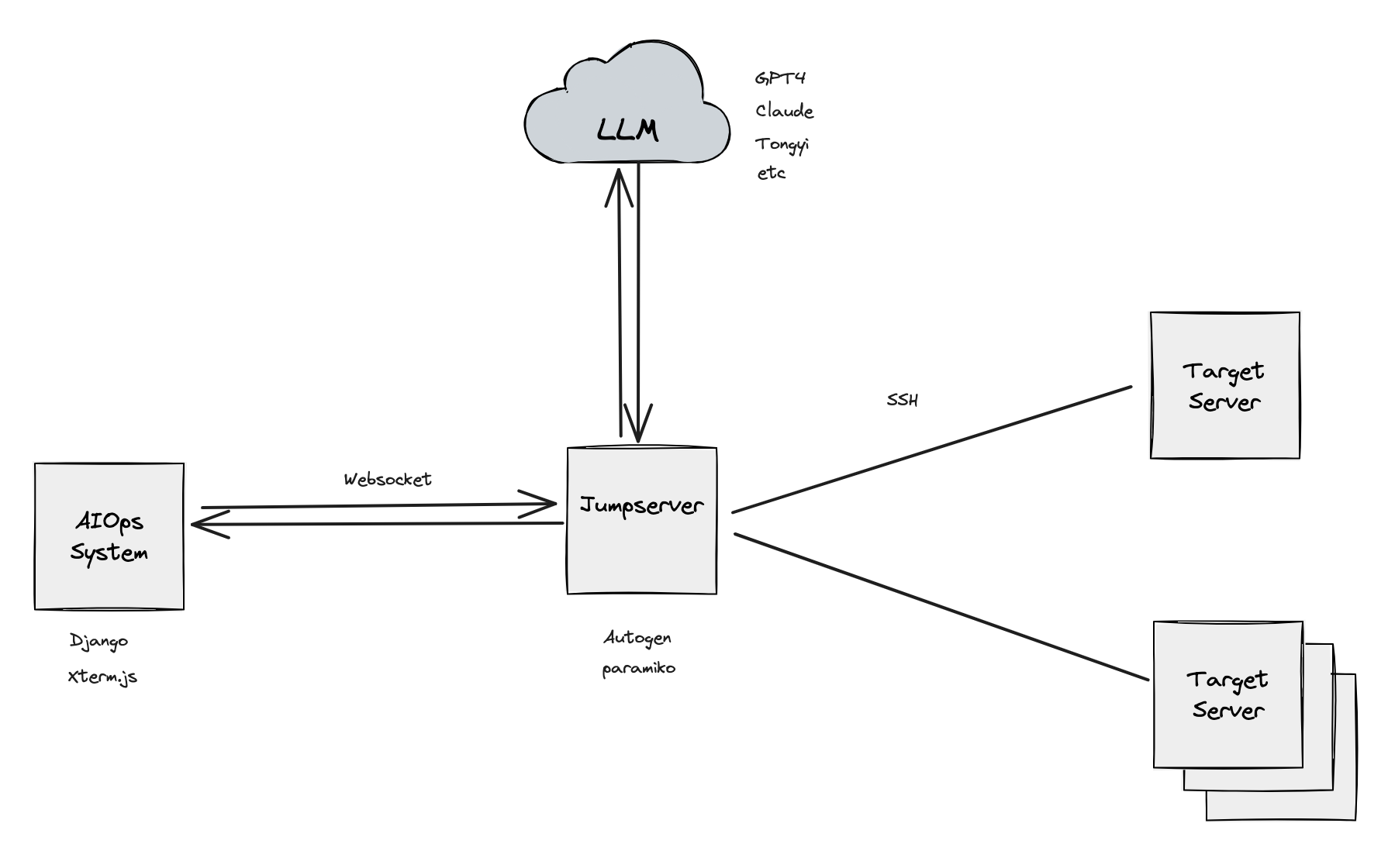

方案设计

利用堡垒机与所有目标机器互通,将aiagent部署在此。通过提示词确认专精方向、连接方式。后端使用Django开启websocket,前端使用xterm.js模拟终端

重点

- Xterm.js学习曲线陡峭,捕获中文、英文、空格、回退,快捷键等均需要自定义。在即将完成时看到有封装更简单的项目webssh

- Autogen中与openai通信使用了api.openai.com,改对应库中的域名至代理域名

- websocket模式需要配置asgi使用,加载静态文件有差别。consumers.py和routing.py需自定义

- AIagent中提示词需要明确,注意模型的上下文限制,通过提示词截取部分结果