Mac Studio地表最强推理神器

在今年的大模型落地背景下,敏感信息不和共有模型交互。我们分别评测了 A100 8卡、4090、H800、H20,动辄百万级,在前期探索阶段很难拿到产出数据支撑。

梳理需求后发现,90%场景是推理,只有AI部门涉及训练任务。推理性能和性价比成为重点。

此时注意到,Mac Studio在M2 Ultra芯片上采用了统一内存架构(内存≈显存),可用于推理大型模型。油管也已有博主实测运行 deepseek-R1:671b。

最终选择购入最新的M3 Ultra Mac Studio

- CPU&GPU:Apple M3 Ultra 芯片 (32 核中央处理器、80 核图形处理器和 32 核神经网络引擎)

- MEM:512G统一内存

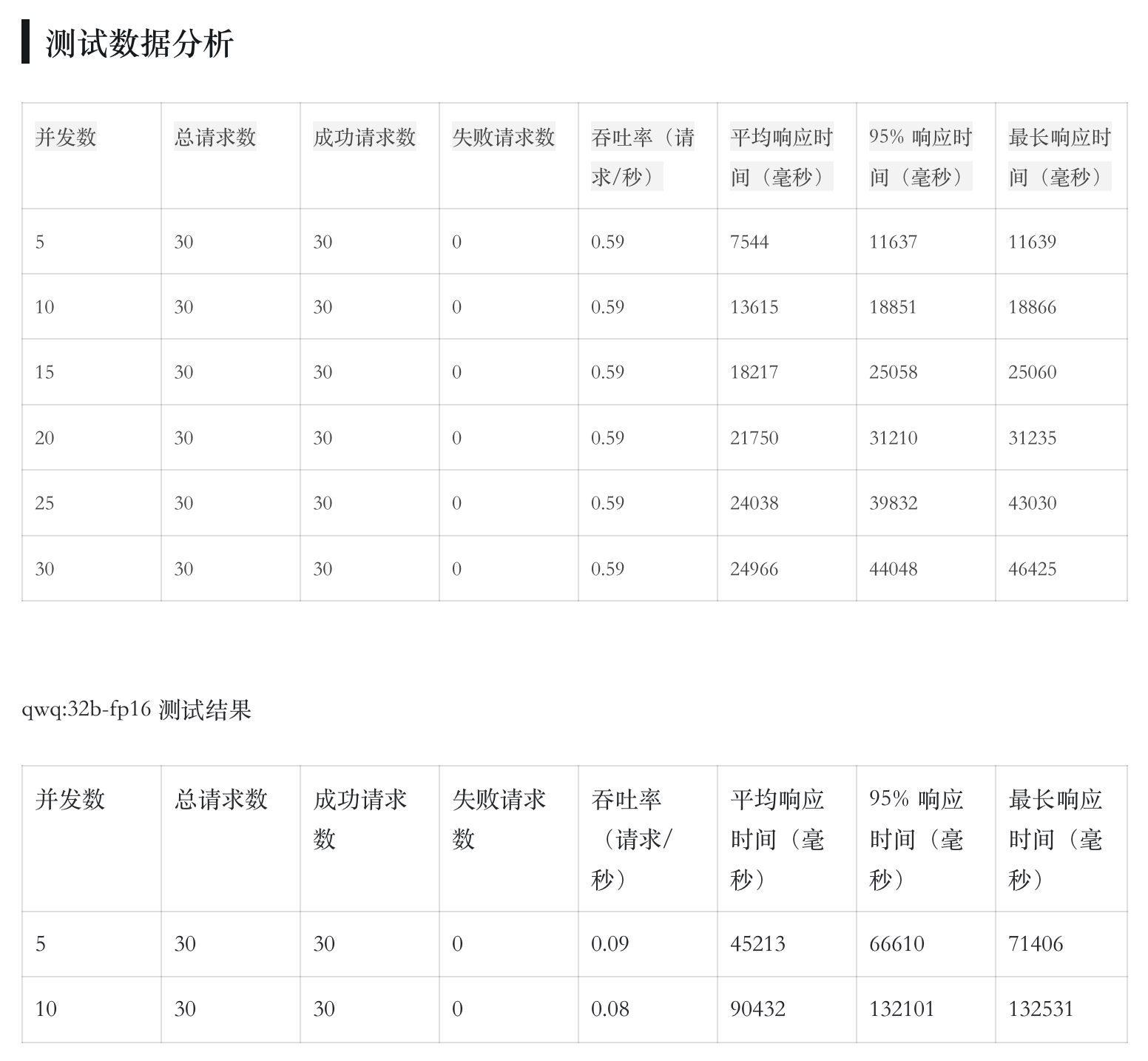

价格不到7万。实测默认参数下,可以运行 deepseek-R1:671b,30个并发响应轻松,推理速度可接受。

Mac Studio并不是为全天候服务器设计

虽然推理能力超出预期,但Mac Studio天生不适合全天候服务器,主要存在以下问题:

- 重启后需本地登录。即使启用远程登录(SSH)和屏幕共享(VNC),每次重启后,必须在本机物理登录一次,远程连接功能才能恢复。这使得无人值守场景下,稳定性有损失。

- 服务部署与Linux不同。在Mac上安装、配置守护进程,与Linux系统差异较大,需要额外适配工作。例如,Ollama绑定地址、环境变量设置,都需要用

launchctl手动配置。

稳定运行的必要设置

为了最大化稳定性,必须手动关闭系统的各种休眠机制:

# 防止系统进入睡眠

sudo systemsetup -setcomputersleep Never

# 防止显示器睡眠

sudo systemsetup -setdisplaysleep Never

# 防止硬盘休眠

sudo systemsetup -setharddisksleep Never

# 验证配置

systemsetup -getcomputersleep

systemsetup -getdisplaysleep

systemsetup -getharddisksleep

# 设置Ollama监听所有IP地址

launchctl setenv OLLAMA_HOST "0.0.0.0"

# 调整GPU共享内存限制,必选!否则大尺寸模型跑不起来

sudo sysctl iogpu.wired_limit_mb=491520